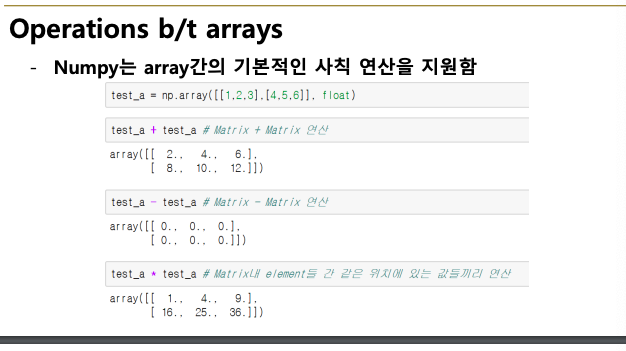

Numerical Python - Numpy 학습 목표 이번 강의에서는 파이썬의 과학 계산용 패키지인 numpy 의 여러 특징과 기능, 코드를 작성하는 방법 등을 배웁니다. numpy ndarray Handling shape Indexing Slicing Creation function Operation functions array operations Comparisons (이 글 범위) Boolean Index Fancy Index numpy data i/o 강의 영상 Numerial Python - numpy Data handling section https://blog.naver.com/boostcamp_official/222345119688 부스트캠프 AI Tech 2기 자가 진단 문항 부스트캠프..