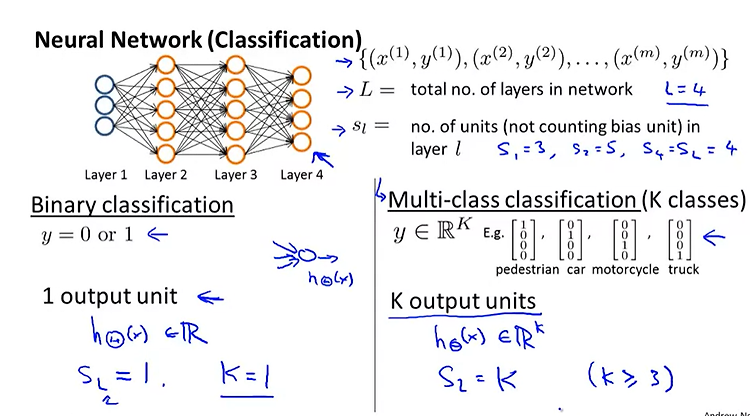

궁극적 꿈은 생각하는 기계를 만들자였겠지? 그러다 보니 뇌를 공부하게 됨 복잡하게 연결되어 있고 뉴런이라는 유닛이 단순 동작하는데도 어떻게 이렇게 복잡한 기능을 하게 된 것일까? weight * x ===> sum ===> bias라는 항목 더해지고 ===> 다 모여있는 값이 역치 이상이면 활성화 or not 그래서 처음 모델 activation functions 이 기계를 하드웨어로 만든게 위 기계들 선을 다 꼬아서 만들고 -> 각 weight 다이얼 돌려서 바꿔가면서 출력하게 했다. 많은 관심을 끌자 호황된 약속을 하게 됐다. 58년 기사를 보면 the navy revelaed elctronic computer that it expects to walk talk see write and reprodu..