sequence data

we dont understand one word only. we understand based on previous words and this word

but NN CNN cannot do this

그래서 이전의 계산이 영향을 미치는 구조를 고민

실제로는 이렇게 구현했다고 보면 된다

이전의 연산이 영향을 미친다

Recurrent Neural Network

계산 어떻게 해?

state H 를 계산하기 위해 old state , x input vector 을 function에 넣는다

여기서 사람들이 이렇게 하나의 그림으로 표현하는 이유는 function이 동일하기 때문이다.

가장 기초적인 연산 방법은

wx 을 이용해서 구현하는 것

w *h + w x

각각의 weight을 곱하고 더해서 tan sigmoid랑 같은 모드? 에 넣어서

h 를 구하고 y를 구할 때는 W * h 해서 나온다.

그렇다면 이게 몇번 거치는각는 weight에 따라 달라짐? 아닌가 반댄가 weight가 몇번에 따라 달라지는가?

hello가 있다고 하자

character를 줌 하나씩 h e l l o 이렇게 주었을 때

연관 검색어처럼 그다음 단어 예측하게 해주고 싶다...

이렇게 character-level language model 예측하는 모델

가장 쉬운 방법은 one hot encoding

각각 캐릭터 해당하는 자리에 넣는다

위 공식을 사용해서 넣는다

가장 처음 값은 없으니까 h t-1 은 0이겠지

weight 곱해서 나옴

그다음 값은 동시 이용해서 구하겠지

계속 진행하겠지

영향을 미쳐서 나온는 것이기 때문에

output layer y를 뽑아 낼때는 helo 중 해당하는 레이블을 예측해준다

원하는 건 -1, o 가 1.2 에러겠지

cost를 구하면 softmax로 구하고 계속 돌리면 학습하겠지

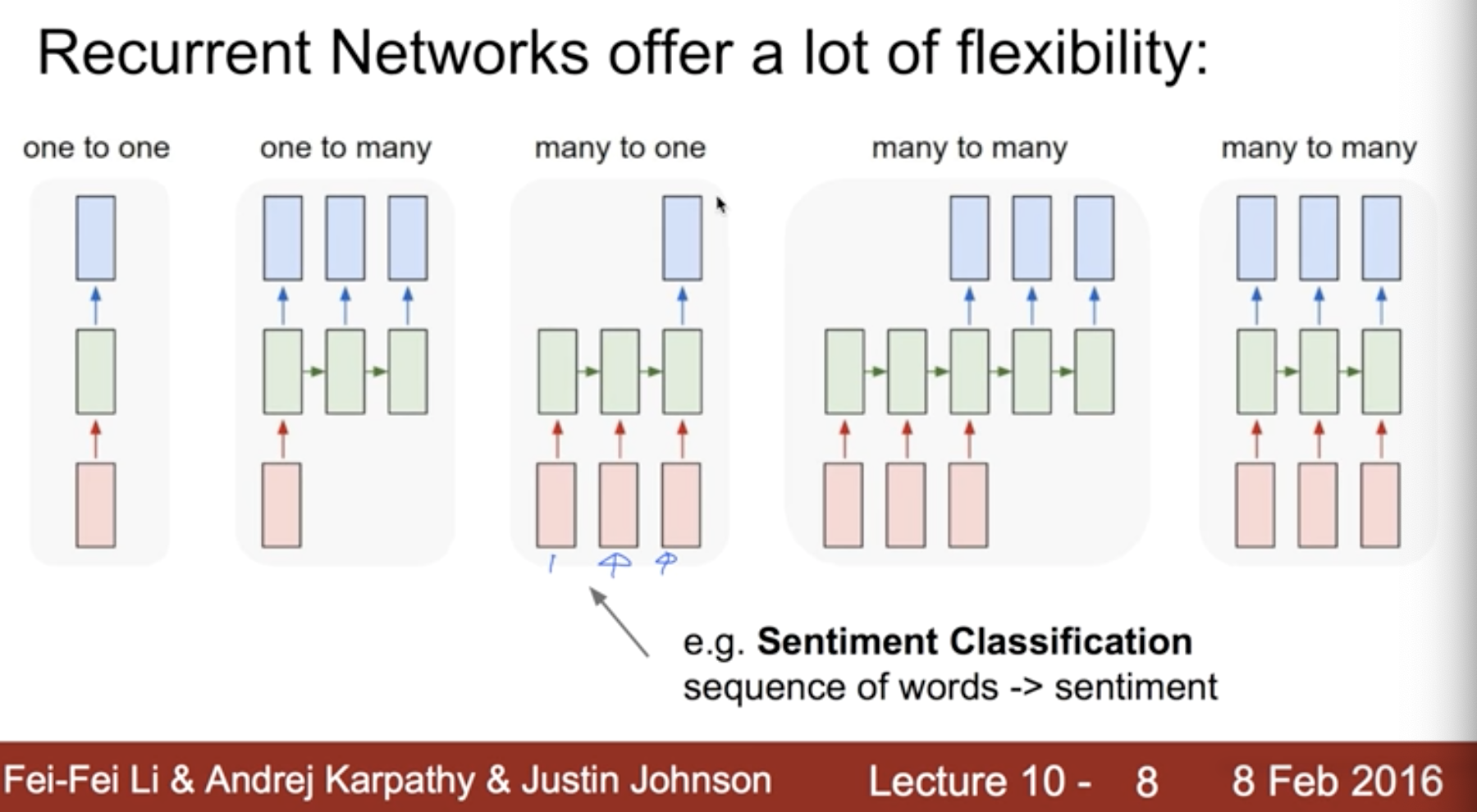

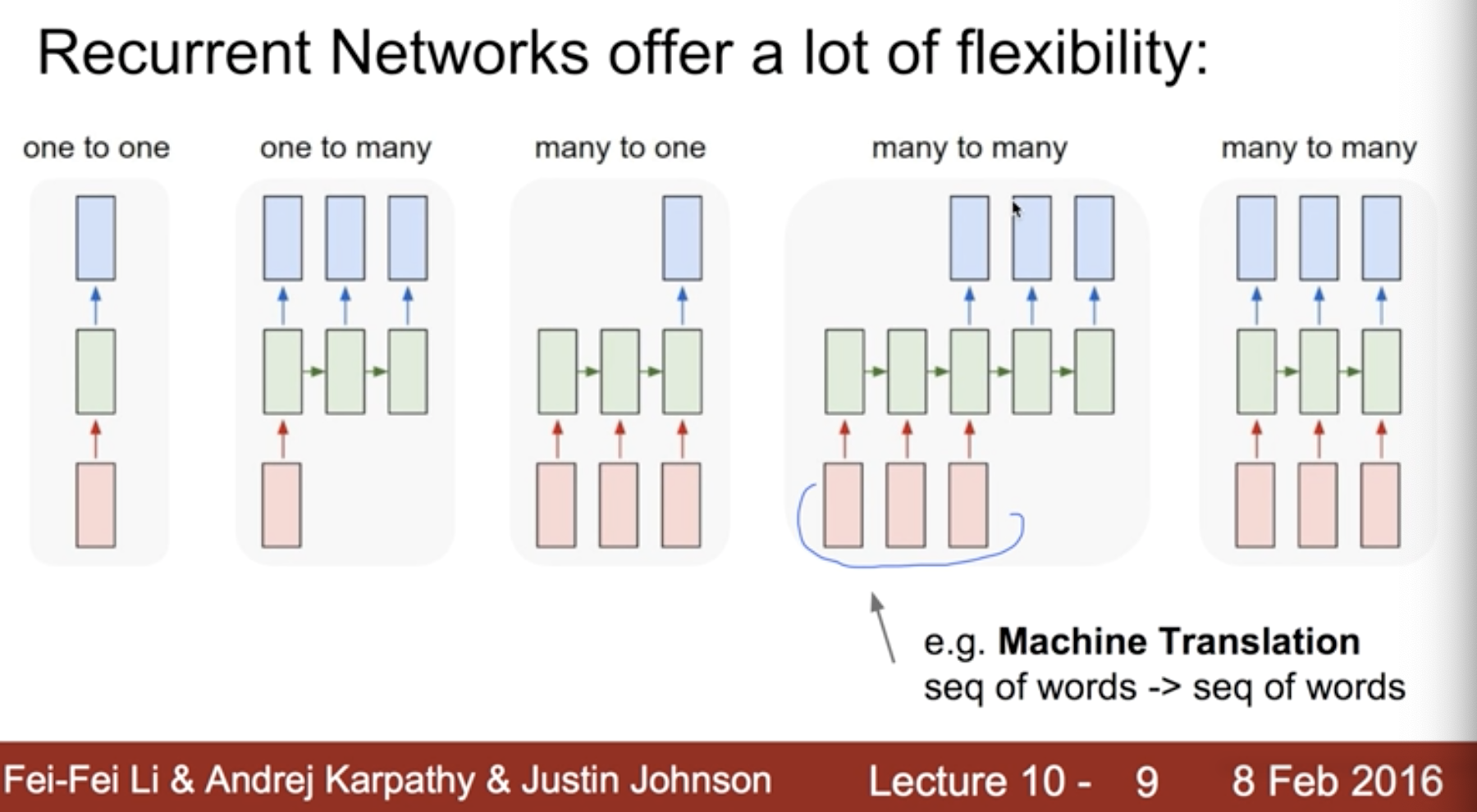

이 RNN을 활용하는 방법 다양하다

language modeling

speech recognition

machine translation

시퀀스를 입력받고 새로운 시퀀스를 출력

conversation modeling question answering

image video captioning

image generation

어떻게 rnn을 구성하느냐 따라 달라진다

이미지 캡션은 두번째

문자 입력방법

machine transaltion 은 이 구조

video는 프레임이 여러개니까

RNN 여러개 layer둘 수 있다

rnn이랑 비슷한데 다른 모델 lstm

RNN basics

'머신러닝,딥러닝 > tensorflow' 카테고리의 다른 글

| lec11 CNN basics tensorflow (0) | 2021.01.25 |

|---|---|

| lec11 ConvNet 의 conv 레이어 만들기 (0) | 2021.01.25 |

| lec10 xsigmoid 보다 ReLU가 더 좋아 (0) | 2021.01.24 |

| lec09 XOR 문제 딥러닝으로 풀기 (0) | 2021.01.24 |

| lec08 tensor manipulation(reshape, stack, zip, one_hot ..) (0) | 2021.01.22 |

| lec08 deep neural network for everyone (0) | 2021.01.22 |

| lec07 learning rate, data preprocessing overfitting (0) | 2021.01.21 |

| lec06 multinominal 개념 소개 (0) | 2021.01.21 |